FaceChain 本地部署与使用教程

打造你的 AI 数字人,从训练到生成一站式指南

1 系统环境安装

1.1 系统环境要求

FaceChain是一个组合模型,使用了包括PyTorch和TensorFlow在内的机器学习框架,以下是已经验证过的主要环境依赖:

- python环境: py3.8, py3.10

- pytorch版本: torch2.0.0, torch2.0.1

- tensorflow版本: 2.8.0, tensorflow-cpu

- CUDA版本: 11.7

- CUDNN版本: 8+

- 操作系统版本: Ubuntu 20.04, CentOS 7.9

- GPU型号: Nvidia-A10 24G

1.1.1 资源要求

- GPU: 显存占用约19G

- 磁盘: 推荐预留50GB以上的存储空间

1.2 autodl 机器

内蒙古区域网络快 芜湖网络慢

选的 Miniconda conda3 Python 3.10(ubuntu22.04) Cuda 11.8 RTX 3090(24GB)

ssh -p 48758 root@region-31.seetacloud.com bZHlCJ1ttu

目录说明:

╔═════════════════╦════════╦════╦═════════════════════════════════════════════════════════════════════════╗

║目录 ║名称 ║速度║说明 ║

╠═════════════════╬════════╬════╬═════════════════════════════════════════════════════════════════════════╣

║/ ║系 统 盘║一般║实例关机数据不会丢失,可存放代码等。会随保存镜像一起保存。 ║

║/root/autodl-tmp ║数 据 盘║ 快 ║实例关机数据不会丢失,可存放读写IO要求高的数据。但不会随保存镜像一起保存 ║

║/root/autodl-nas ║网 盘║ 慢 ║可以实现多实例间的文件同步共享,不受实例开关机和保存镜像的影响。 ║

║/root/autodl-fs ║文件存储║一般║可以实现多实例间的文件同步共享,不受实例开关机和保存镜像的影响。 ║

╚═════════════════╩════════╩════╩═════════════════════════════════════════════════════════════════════════╝

CPU :16 核心

内存:42 GB

GPU :NVIDIA GeForce RTX 3090, 1

存储:

系 统 盘 / :20% 6G/30G

数 据 盘 /root/autodl-tmp:1% 8.0K/50G

网 盘 /root/autodl-nas:未挂载

文件存储 /root/autodl-fs :未挂载1.3 环境确认

nvidia-smi

pip3 show torch

nvcc --version

python -c "import torch; print('PyTorch'); print(torch.version.cuda);print(torch.cuda.is_available())"其它:

ldconfig -p | grep cuda

ldconfig -p | grep cudnn

conda list | grep cudatoolkit

conda list | grep cudnn

查询平台内置镜像中的cuda版本

ldconfig -p | grep cuda 或者检测系统cuda版本: `nvcc --version`

libnvrtc.so.11.0 (libc6,x86-64) => /usr/local/cuda-11.0/targets/x86_64-linux/lib/libnvrtc.so.11.0

libnvrtc.so (libc6,x86-64) => /usr/local/cuda-11.0/targets/x86_64-linux/lib/libnvrtc.so

libnvrtc-builtins.so.11.0 (libc6,x86-64) => /usr/local/cuda-11.0/targets/x86_64-linux/lib/libnvrtc-builtins.so.11.0

查询平台内置镜像中的cudnn版本

ldconfig -p | grep cudnn

libcudnn_ops_train.so.8 (libc6,x86-64) => /usr/lib/x86_64-linux-gnu/libcudnn_ops_train.so.8

libcudnn_ops_train.so (libc6,x86-64) => /usr/lib/x86_64-linux-gnu/libcudnn_ops_train.so

libcudnn_ops_infer.so.8 (libc6,x86-64) => /usr/lib/x86_64-linux-gnu/libcudnn_ops_infer.so.8

libcudnn_ops_infer.so (libc6,x86-64) => /usr/lib/x86_64-linux-gnu/libcudnn_ops_infer.so

上边的输出日志.so后的数字即为版本号。如果你通过conda安装了cuda那么可以通过以下命令查看:

conda list | grep cudatoolkit

cudatoolkit 10.1.243 h6bb024c_0 defaults

conda list | grep cudnn

cudnn 7.6.5 cuda10.1_0 defaults1.4 facechain 安装

conda create -n facechain python=3.8 # 已验证环境:3.8 和 3.10

conda init bash #autodl需要初始化

conda activate facechain

GIT_LFS_SKIP_SMUDGE=1 git clone https://github.com/modelscope/facechain.git --depth 1

pip3 install -r requirements.txt

pip3 install -U openmim

mim install mmcv-full==1.7.0 或mim install mmcv-full==1.7.0 -H 'X-INSTALL-ARGS: -j8'

# 进入facechain文件夹,执行

#指定模型下载到指定盘,目录 很重要。

cd facechain

export MODELSCOPE_CACHE=/root/autodl-tmp/cache/modelscope

python3 app.py

# Note: FaceChain目前支持单卡GPU,如果您的环境有多卡,请使用如下命令

# CUDA_VISIBLE_DEVICES=0 python3 app.py

# 最后点击log中生成的URL即可访问页面。备注:如果是Windows环境还需要注意以下步骤:

# 1. 重新安装pytorch、与tensorflow匹配的numpy

# 2. pip方式安装mmcv-full: pip3 install mmcv-full1.5 问题解决

1.5.1 问题1

_check_cuda_version(compiler_name, compiler_version)

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/torch/utils/cpp_extension.py", line 413, in _check_cuda_version

raise RuntimeError(CUDA_MISMATCH_MESSAGE.format(cuda_str_version, torch.version.cuda))

RuntimeError:

The detected CUDA version (11.8) mismatches the version that was used to compile

PyTorch (12.1). Please make sure to use the same CUDA versions.

发现系统的cuda和pytorch安装的cude不一致。系统的cuda为11.8 pytorch的cuda为12.1. pip重新安装pytorch 。 torch==2.0.1+cu118

pip install –force-reinstall torch==2.0.1+cu118 –extra-index-url https://download.pytorch.org/whl/cu118

检测系统cuda版本: nvcc --version

检测torch cuda版本

import torch;

print(torch.version.cuda) 直接打印CUDA版本字符串,如12.1 。

注意 机器重启后,或pip install onnxruntime==1.15.1后 发现pytorch安装的cude又为12.1了。又pip重新安装 torch

pip install –force-reinstall torch==2.0.1+cu118 –extra-index-url https://download.pytorch.org/whl/cu118

如果系统的cuda和pytorch安装的cude不一致 不一致:

2023-10-05 16:14:10,874 - modelscope - INFO - initialize model from /root/autodl-tmp/cache/modelscope/damo/cv_ddsar_face-detection_iclr23-damofd

Process Process-1:

Traceback (most recent call last):

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/modelscope/utils/registry.py", line 210, in build_from_cfg

return obj_cls._instantiate(**args)

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/modelscope/models/base/base_model.py", line 67, in _instantiate

return cls(**kwargs)

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/modelscope/models/cv/face_detection/scrfd/damofd_detect.py", line 31, in __init__

super().__init__(model_dir, **kwargs)

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/modelscope/models/cv/face_detection/scrfd/scrfd_detect.py", line 36, in __init__

from mmdet.models import build_detector

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/mmdet/models/__init__.py", line 2, in <module>

from .backbones import * # noqa: F401,F403

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/mmdet/models/backbones/__init__.py", line 2, in <module>

from .csp_darknet import CSPDarknet

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/mmdet/models/backbones/csp_darknet.py", line 11, in <module>

from ..utils import CSPLayer

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/mmdet/models/utils/__init__.py", line 13, in <module>

from .point_sample import (get_uncertain_point_coords_with_randomness,

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/mmdet/models/utils/point_sample.py", line 3, in <module>

from mmcv.ops import point_sample

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/mmcv/ops/__init__.py", line 2, in <module>

from .active_rotated_filter import active_rotated_filter

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/mmcv/ops/active_rotated_filter.py", line 10, in <module>

ext_module = ext_loader.load_ext(

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/mmcv/utils/ext_loader.py", line 13, in load_ext

ext = importlib.import_module('mmcv.' + name)

File "/root/miniconda3/envs/facechain/lib/python3.8/importlib/__init__.py", line 127, in import_module

return _bootstrap._gcd_import(name[level:], package, level)

ImportError: /root/miniconda3/envs/facechain/lib/python3.8/site-packages/mmcv/_ext.cpython-38-x86_64-linux-gnu.so: undefined symbol: _ZNK3c106SymIntltEl

During handling of the above exception, another exception occurred:

Traceback (most recent call last):

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/modelscope/utils/registry.py", line 212, in build_from_cfg

return obj_cls(**args)

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/modelscope/pipelines/cv/face_detection_pipeline.py", line 36, in __init__

super().__init__(model=model, **kwargs)

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/modelscope/pipelines/base.py", line 99, in __init__

self.model = self.initiate_single_model(model)

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/modelscope/pipelines/base.py", line 53, in initiate_single_model

return Model.from_pretrained(

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/modelscope/models/base/base_model.py", line 179, in from_pretrained

model = build_model(model_cfg, task_name=task_name)

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/modelscope/models/builder.py", line 35, in build_model

model = build_from_cfg(

File "/root/miniconda3/envs/facechain/lib/python3.8/site-packages/modelscope/utils/registry.py", line 215, in build_from_cfg

raise type(e)(f'{obj_cls.__name__}: {e}')

ImportError: DamoFdDetect: /root/miniconda3/envs/facechain/lib/python3.8/site-packages/mmcv/_ext.cpython-38-x86_64-linux-gnu.so: undefined symbol: _ZNK3c106SymIntltEl重新pip安装 torch,解决ok。

然后 人物形象训练ok 无限风格形象写真ok 固定模板形象写真ok

[基模型选择: 写实 写真] [人物LoRA] [风格选择] [姿态控制] 可以上传LoAR(使用自定义LoRA文件需手动输入prompt),风格选择形象权重,姿态控制有男女生控制。

person9 LoRA

参考:

Ubuntu的pip详细安装pytorch 过程

- 显卡驱动要装好,确保nvidia-smi可以运行

推荐在conda环境中用pip进行安装

- 进入到conda虚拟环境中,安装torch环境 截至到目前的最新版是torch2.0.1,cuda11.8。虽然我的显卡驱动自带的cuda是12.0但也可以安装,推荐采用python3.10,因为当前的torch.compile只支持到python3.10。

conda activate torch2.0 conda install cudatoolkit cudnn pip install torch==2.0.1+cu118 –extra-index-url https://download.pytorch.org/whl/cu118 pip install torchmetrics tensorboard tensorboardX

- 检查是否可以调用gpu ·

import torch

torch.cuda.is_available()如果是True,那就ok啦 。结果为False,那就需要覆盖一下torch

pip install --force-reinstall torch==2.0.1+cu118 --extra-index-url https://download.pytorch.org/whl/cu1181.5.2 问题2

ValueError: This ORT build has [‘AzureExecutionProvider’, ‘CPUExecutionProvider’] enabled

执行 「pip install onnxruntime==1.15.1」已解决,python环境3.8,其他步骤按README执行即可

最好修改requirements.txt

accelerate

transformers

diffusers

onnxruntime==1.15.1

modelscope

Pillow

opencv-python

torchvision

mmdet==2.26.0

mmengine

numpy==1.22.0

protobuf==3.20.1

timm

scikit-image

gradio

controlnet_aux==0.0.6

mediapipe

python-slugify

#tensorflow==2.8.0

#tensorflow-cpu # slower but no cuda conflicts

# mmcv-full (need mim install) #我是手动安装mmcv-full: pip3 install -U openmim mim install mmcv-full==1.7.0 tensorflow没有安装。pip list |grep tensorflow是空的。但系统,能出图,没有报错。不知是否使用gpu了

pip install --no-cache-dir --ignore-installed --force-reinstall --no-warn-conflicts tensorflow==2.8.0/root/miniconda3/envs/facechain/lib/python3.8/site-packages/modelscope/hub/constants.py

/opt/conda/lib/python3.8/site-packages/modelscope/hub/constants.py

1.5.3 问题3 对外webui

WebUI service

pip3 install gradio

pip3 install controlnet_aux==0.0.6

pip3 install python-slugify

##如果要webui访问 添加上面3行代码,增加frpc frpc_linux_amd64.tar.gz 到site-packages/gradio目录

export MODELSCOPE_CACHE=/root/autodl-tmp/cache/modelscope

python3 app.py/root/miniconda3/envs/facechain/lib/python3.8/site-packages/gradio

- Download this file: https://cdn-media.huggingface.co/frpc-gradio-0.2/frpc_linux_amd64

- Rename the downloaded file to: frpc_linux_amd64_v0.2

- Move the file to this location: /root/miniconda3/envs/facechain/lib/python3.8/site-packages/gradio

1.5.3.1 方式2

- SSH反向代理

在本地执行:

ssh -N -L 8080:127.0.0.1:7860 root@region-31.seetacloud.com -p 48758 或者

ssh -CNg -L 8080:127.0.0.1:7860 root@region-31.seetacloud.com -p 48758这样会通过SSH把内部的7860端口转发到本地的8080端口。

然后访问本地8080端口,实际上是访问内部7860端口的web服务。

2 或者 SSH动态端口转发

ssh -D 1080 -N root@region-31.secloud.com -p 42158在本地设置socks5代理为1080端口,然后通过代理访问内部web服务。

1.5.4 问题4 空间大小

系统盘: / 总共30G

~/autodl-tmp# df -h

Filesystem Size Used Avail Use% Mounted on

overlay 30G 16G 15G 51% /数据盘: /root/autodl-tmp 总共50G

下载的一些风格lora模型和人脸处理相关的模型默认到.cache目录,能够改到指定的目录吗

指定模型下载到指定盘,目录 很重要。 export MODELSCOPE_CACHE=/root/autodl-tmp/cache/modelscope**

(facechain) root@autodl-container-72c311a010-157450b6:~/autodl-tmp# du -sh /root/autodl-tmp/cache/*

29G /root/autodl-tmp/cache/modelscope

(facechain) root@autodl-container-72c311a010-157450b6:~/autodl-tmp# du -sh /root/autodl-tmp/cache/modelscope/*

79M /root/autodl-tmp/cache/modelscope/Cherrytest

8.1G /root/autodl-tmp/cache/modelscope/YorickHe

716K /root/autodl-tmp/cache/modelscope/ast_indexer

7.7G /root/autodl-tmp/cache/modelscope/damo

13G /root/autodl-tmp/cache/modelscope/ly261666

0 /root/autodl-tmp/cache/modelscope/tempdu -sh /root/miniconda3/pkgs/ && rm -rf /root/miniconda3/pkgs/* # conda的历史包

du -sh /root/.local/share/Trash && rm -rf /root/.local/share/Trash # jupyterlab的回收站

以下目录是可能占用较大空间,但需要您根据实际情况清理的目录:

du -sh /tmp/

du -sh /root/.cacheAUTOMATIC1111/stable-diffusion-webui/NovelAI-Consolidation-Package-3.1:v10 xiaolxl (本地整合版)NovelAI+DreamBooth+DeepdanBooru+Xformers+官网效果+可视化启动界面整合包是NovelAI-Consolidation-Package的第三代版本 41.6k 框架:PyTorch:2.0.0 CUDA版本:11.8 镜像大小:23.78GB 之前下载这个安装 导致28G就没空间了。pip安装就报错。删除statblediffusion 模型文件和pip cache condacache也释放不了多少空间。 只能 Miniconda conda3 Python 3.10(ubuntu22.04) Cuda 11.8 RTX 3090(24GB) 自己安装。

1.5.5 问题5 labeled/metadata.jsonl

[FileNotFoundError: Errno 2] No such file or directory: ‘/tmp/qw/training_data/ly261666/cv_portrait_model/test_labeled/metadata.jsonl’

模型下载超时,导致preprocess没正确执行,就出现metadata.jsonl找不到问题。

- 环境变量配置 export MODELSCOPE_CACHE=/facechain/models

- 改下timeout设置 /opt/conda/lib/python3.8/site-packages/modelscope/hub/constants.py

1.5.6 nsfw

facechain/facechain/constants.py

neg_prompt = '(nsfw:2), paintings, sketches, (worst quality:2), (low quality:2), ' \

'lowers, normal quality, ((monochrome)), ((grayscale)), logo, word, character, bad hand, tattoo, (username, watermark, signature, time signature, timestamp, artist name, copyright name, copyright),'\

'low res, ((monochrome)), ((grayscale)), skin spots, acnes, skin blemishes, age spot, glans, extra fingers, fewer fingers, strange fingers, bad hand, mole, ((extra legs)), ((extra hands))'

pos_prompt_with_cloth = 'raw photo, masterpiece, chinese, {}, solo, medium shot, high detail face, looking straight into the camera with shoulders parallel to the frame, photorealistic, best quality'

pos_prompt_with_style = '{}, upper_body, raw photo, masterpiece, solo, medium shot, high detail face, photorealistic, best quality'

facechain/app.py

pos_prompt = 'raw photo, masterpiece, chinese, simple background, high-class pure color background, solo, medium shot, high detail face, photorealistic, best quality, wearing T-shirt'

neg_prompt = 'nsfw, paintings, sketches, (worst quality:2), (low quality:2) ' \

'lowers, normal quality, ((monochrome)), ((grayscale)), logo, word, character'2 进阶玩法

2.1 个性开发

2.1.1 更多写真风格

inference.py 修改 main_model_inference 函数中Lora模型的路径 ,只用自定义的safetensors格式的风格LoAR模型,替代原有的风格。

2.1.2 修改写真的图片的具体内容

例如服装、物品等,修改main_diffusion_inference中的正向负向提示词 prompt ,在写真中产生对应内容。

2.1.3 调整人脸细节

在后面处理中调整人脸细节,可以修改face_swap_fn人脸融合函数 中的人脸融合模型。 也可以修改人脸的提示词。

2.1.4 命令训练推理

如果不想启动服务,而是直接在命令行进行开发调试等工作,FaceChain也支持在python环境中直接运行脚本进行训练和推理。在克隆后的文件夹中直接运行如下命令来进行训练:

PYTHONPATH=. sh train_lora.sh "ly261666/cv_portrait_model" "v2.0" "film/film" "./imgs" "./processed" "./output"参数含义:

ly261666/cv_portrait_model: ModelScope模型仓库的stable diffusion基模型,该模型会用于训练,可以不修改

v2.0: 该基模型的版本号,可以不修改

film/film: 该基模型包含了多个不同风格的子目录,其中使用了film/film目录中的风格模型,可以不修改

./imgs: 本参数需要用实际值替换,本参数是一个本地文件目录,包含了用来训练和生成的原始照片

./processed: 预处理之后的图片文件夹,这个参数需要在推理中被传入相同的值,可以不修改

./output: 训练生成保存模型weights的文件夹,可以不修改等待5-20分钟即可训练完成。用户也可以调节其他训练超参数,训练支持的超参数可以查看train_lora.sh的配置,或者facechain/train_text_to_image_lora.py中的完整超参数列表。

进行推理时,请编辑run_inference.py中的代码:

# 使用深度控制,默认False,仅在使用姿态控制时生效

use_depth_control = False

# 使用姿态控制,默认False

use_pose_model = False

# 姿态控制图片路径,仅在使用姿态控制时生效

pose_image = 'poses/man/pose1.png'

# 填入上述的预处理之后的图片文件夹,需要和训练时相同

processed_dir = './processed'

# 推理生成的图片数量

num_generate = 5

# 训练时使用的stable diffusion基模型,可以不修改

base_model = 'ly261666/cv_portrait_model'

# 该基模型的版本号,可以不修改

revision = 'v2.0'

# 该基模型包含了多个不同风格的子目录,其中使用了film/film目录中的风格模型,可以不修改

base_model_sub_dir = 'film/film'

# 训练生成保存模型weights的文件夹,需要保证和训练时相同

train_output_dir = './output'

# 指定一个保存生成的图片的文件夹,本参数可以根据需要修改

output_dir = './generated'

# 使用凤冠霞帔风格模型,默认False

use_style = False之后执行:

python run_inference.py即可在output_dir中找到生成的个人数字形象照片。

2.1.5 代码解读

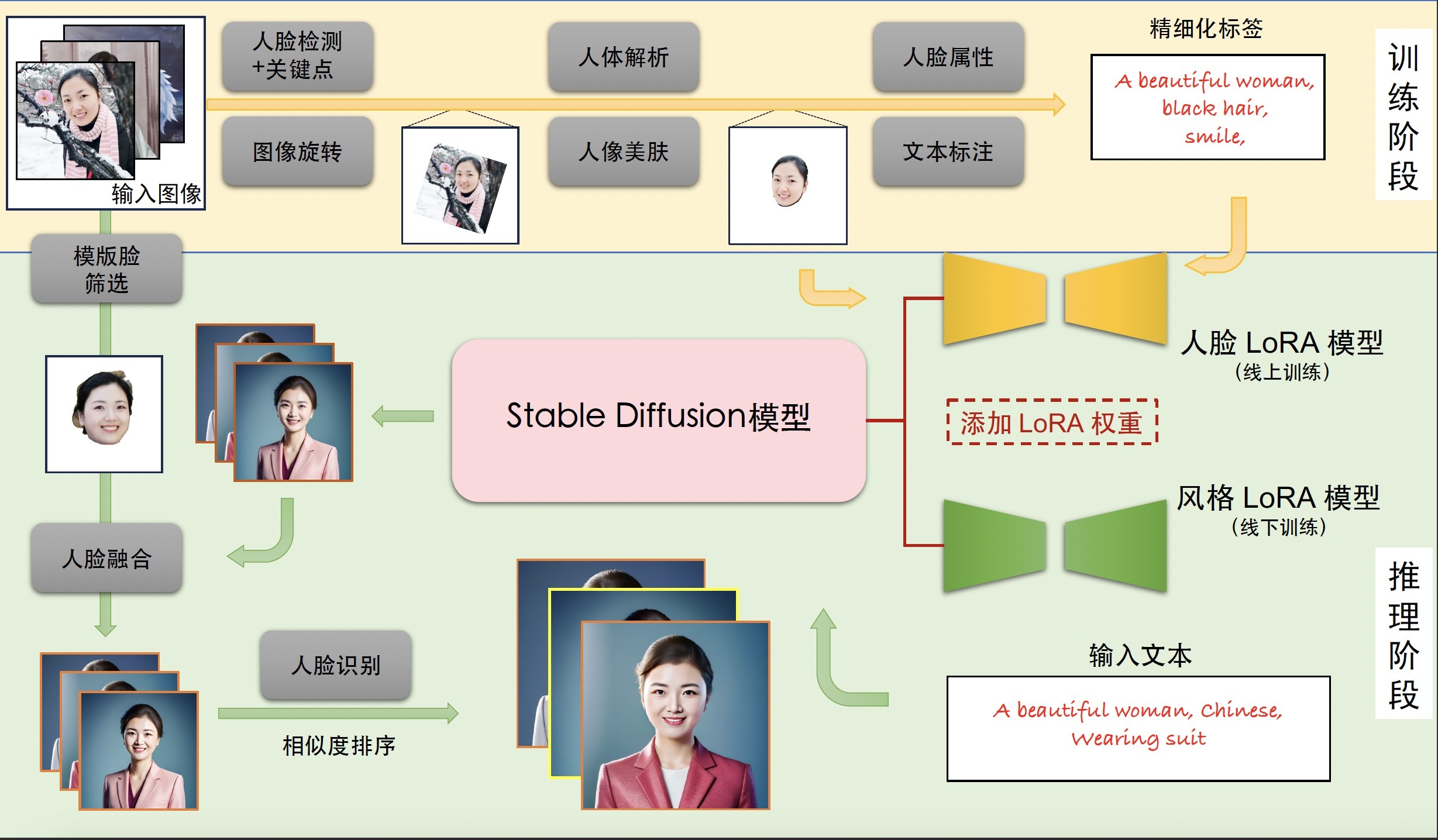

个人写真模型的能力分为训练与推断两个阶段,训练阶段生成用于微调Stable Diffusion模型的图像与文本标签数据,得到人脸LoRA模型;推断阶段基于人脸LoRA模型和风格LoRA模型生成个人写真图像。

3 训练阶段

输入:用户上传的包含清晰人脸区域的图像

输出:人脸LoRA模型

描述:首先,我们分别使用基于朝向判断的图像旋转模型,以及基于人脸检测和关键点模型的人脸精细化旋转方法处理用户上传图像,得到包含正向人脸的图像;接下来,我们使用人体解析模型和人像美肤模型,以获得高质量的人脸训练图像;随后,我们使用人脸属性模型和文本标注模型,结合标签后处理方法,产生训练图像的精细化标签;最后,我们使用上述图像和标签数据微调Stable Diffusion模型得到人脸LoRA模型。

4 推断阶段

输入:训练阶段用户上传图像,预设的用于生成个人写真的输入提示词

输出:个人写真图像

描述:首先,我们将人脸LoRA模型和风格LoRA模型的权重融合到Stable Diffusion模型中;接下来,我们使用Stable Diffusion模型的文生图功能,基于预设的输入提示词初步生成个人写真图像;随后,我们使用人脸融合模型进一步改善上述写真图像的人脸细节,其中用于融合的模板人脸通过人脸质量评估模型在训练图像中挑选;最后,我们使用人脸识别模型计算生成的写真图像与模板人脸的相似度,以此对写真图像进行排序,并输出排名靠前的个人写真图像作为最终输出结果。

5 模型列表

附(流程图中模型链接)

[1] 人脸检测+关键点模型DamoFD:https://modelscope.cn/models/damo/cv_ddsar_face-detection_iclr23-damofd

[2] 图像旋转模型:创空间内置模型

[3] 人体解析模型M2FP:https://modelscope.cn/models/damo/cv_resnet101_image-multiple-human-parsing

[4] 人像美肤模型ABPN:https://www.modelscope.cn/models/damo/cv_unet_skin_retouching_torch

[5] 人脸属性模型FairFace:https://modelscope.cn/models/damo/cv_resnet34_face-attribute-recognition_fairface

[6] 文本标注模型Deepbooru:https://github.com/KichangKim/DeepDanbooru

[7] 模板脸筛选模型FQA:https://modelscope.cn/models/damo/cv_manual_face-quality-assessment_fqa

[8] 人脸融合模型:https://www.modelscope.cn/models/damo/cv_unet_face_fusion_torch

[9] 人脸识别模型RTS:https://modelscope.cn/models/damo/cv_ir_face-recognition-ood_rts

6 其它进阶

人物表情包、人物连环画故事、虚拟试衣间 表情包 人物动态视频 游戏或电影角色设计等高阶段场景 ……

【手把手教程】无限场景风格LoRA与固定人物LoRA的融合-酷蛙FaceChain0826周记(GitHub已4K Star!)_魔搭ModelScope社区-ModelScope魔搭社区

以上风格LoRA分别为:户外花园婚纱、冬季雪景汉服、火焰女神、仙侠风 环境准备 核心文件。

AIGC的代码实践让图片、视频更加有趣。

各类AI写真软件由于其精准的个人形象+精美的生成效果引爆了朋友圈传播,证件照满足了用户刚需,古装照等风格照满足了用户“美照”的需求。

揭秘酷蛙FaceChain开源项目 技术细节-云视频-阿里云开发者社区 (aliyun.com)

7 其它modelscope项目

VideoComposer是由阿里巴巴研发的可控视频生成框架,其可以让用户更灵活地使用文本条件、空间条件和时序条件来生成视频,比如使用草图、深度图或运动向量等多个组合条件合成目标视频,极大地提高了视频灵活性和可控性。本项目相比于之前的开源项目主要增加了无水印数据训练,可使得生成的视频没有水印。此外,本项目目前只支持文本+深度图+Style方便体验

中文CLIP上线啦!8行代码助你快速上手图文检索-云视频-阿里云开发者社区 (aliyun.com)

万物识别:教你一行代码通识万物-云视频-阿里云开发者社区 (aliyun.com)